导读:未来,人工智能的发展和数据存储的进步将会是相辅相成的,数据存储也必将成为人工智能时代重要的一环。当前,AI时代模型算力需求已经远超摩尔定律的速度增长,特别是在深度学习、大模型时代之后,预计5-6个月翻倍。但总体而言,大容量、大带宽等存储芯片将迎来一波人工智能创新应用机遇。

“ChatGPT是人工智能领域的iPhone时刻,也是计算领域有史以来最伟大的技术之一。” 英伟达创始人兼CEO黄仁勋此前这样盛赞ChatGPT。

ChatGPT突然爆火,对大算力芯片提出了更高更多的要求。近日,据韩国经济日报报道,受惠于ChatGPT,三星、SK海力士HBM(high bandwidth memory,高带宽内存)接单量大增。

图片来源:三星半导体

据悉,SK海力士为英伟达供应第三代HBM,搭配英伟达的A100 GPU供ChatGPT使用。另外,英伟达已经将SK海力士的第四代HBM安装至H100,而H100已开始供应ChatGPT服务器所需。同时,韩国业界透露,如今第三代HBM报价飞涨,已是效能最高的DRAM产品的五倍之多,其市场成长率是三星、SK海力士原本预测的两倍以上。

过去的一年,由于低迷的市场表现,各大存储芯片巨头承受着巨大的亏损压力,步入了行业的“寒冬”。然而,ChatGPT等相关AI应用正对惨淡的存储芯片产生积极的影响。那么,未来一年,存储芯片是否迎来新的增量市场机遇?

高性能内存芯片亟待升级

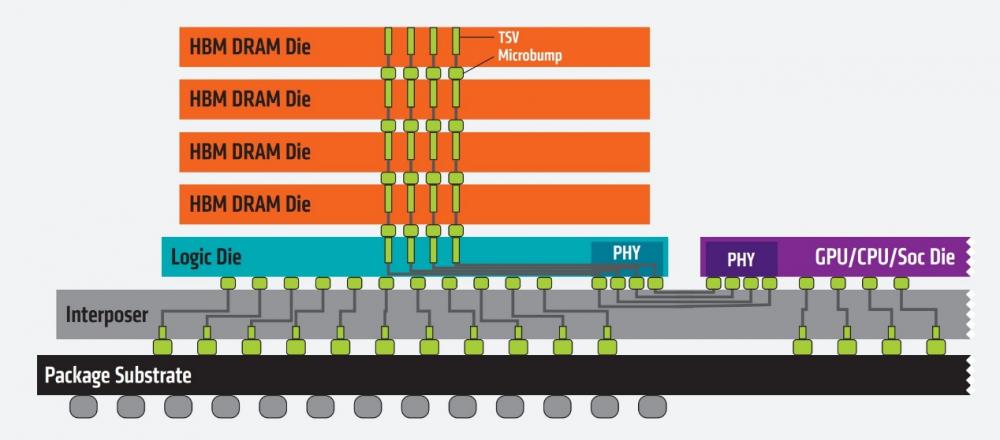

HBM是一种基于3D堆叠工艺的DRAM内存芯片,它就像摩天大厦中的楼层一样可以垂直堆叠。基于这种设计,信息交换的时间将会缩短。这些堆叠的数颗DRAM芯片通过称为“中介层(Interposer)”的超快速互联方式连接至CPU或GPU,最后可将组装好的模块连接至电路板。

HBM的架构 图片来源:AMD

HBM重新调整了内存的功耗效率,能大幅提高数据处理速度,是当下速度最快的DRAM产品,其每瓦带宽比GDDR5高出3倍还多,且HBM比GDDR5节省了94%的表面积。目前,HBM主要被安装在GPU、网络交换及转发设备(如路由器、交换器)、AI加速器、超级计算机及高效能服务器上。

一般而言,HBM作为一种GPU显存存在时,如今虽不算罕见,但因HBM成本高昂,多在高端产品上见到。比如,英伟达面向数据中心的GPU。AMD在消费级GPU上用HBM算是比较少见的例子。

短短两个月,ChatGPT这一超级AI 应用的用户破亿,使全球科技巨头加快了生成式AI应用的布局,也带动了AI应用场景大发展,正掀起新一轮人工智能创新浪潮。

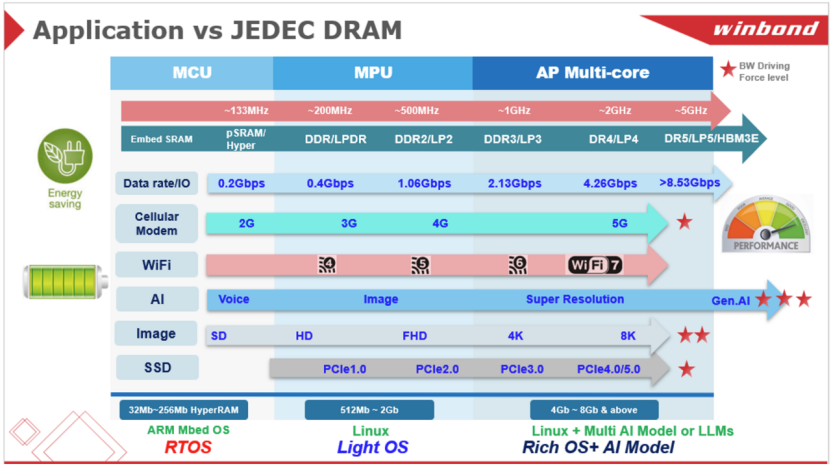

如今,搭载于新兴AI应用的内存芯片亟待升级,主要体现在三大方面:一是ChatGPT这类生成式AI应用需要在海量的训练数据中进行学习,才能实现高质量的生成输出。为了实现关键词识别、图像识别等功能,AI模型需要存储大量的图片和音频信息。

二是面向C端用户的AI应用必须具备快速处理数据的能力,才能向用户实时输出AI计算结果,因此也对内存芯片的数据传输速度提出了更高要求。

三是随着人工智能技术的进一步普及,越来越多的AI应用发生在移动设备和物联网终端设备上,而这些设备大多采用电池供电或充电,对功耗十分敏感。

HBM作为一种带宽远超DDR/GDDR的高速内存,将为大算力芯片提供能力支撑,进而成为相关加速芯片的必然选择,同时生成类模型也会加速HBM内存进一步增大容量和增大带宽。

HBM需求量将激增

众所周知,算力的来源就是芯片。而ChatGPT背后的计算集群使用的是AI芯片,其中以英伟达AI芯片为典型代表。

OpenAI曾表示,ChatGPT是与英伟达和微软合作完成的超级AI。微软在自己的云——Azue HPC Cloud中构建了超级计算机集群,将其提供给OpenAI。据悉,该超级计算机拥有285000个CPU(中央处理器)内核和10000多颗AI芯片。除了算力芯片外,AI对话程序在执行计算期间需要大容量、高速的存储支持,预计高性能存储芯片需求也会增长。

因此,未来,为GPU和人工智能加速器提供数据的高性能高带宽内存(HBM) 的需求将会扩大。从长远来看,随着AI聊天机器人服务的扩展,对用于CPU的128GB或更大容量的高性能HBM和高容量服务器DRAM的需求预计会增加。

据悉,从今年年初开始,三星电子和SK海力士的高带宽存储器(HBM)订单就大幅增加。与其他DRAM相比,HBM通过垂直连接多个DRAM,显著提高了数据处理速度,与CPU和GPU协同工作,可以大幅提高服务器的学习和计算性能。

此前,HBM之所以没有得到大范围应用,就在于其需要复杂的生产工艺和高度先进的技术。目前海力士是全球HBM3显存的主力生产商,占据了60-70%的市场。而三星则凭借着强大的研发实力以及资金投入,也在HBM显存市场上颇有建树。

目前,三星已开发出具运算能力的HBM,不但能储存数据、还能运算数据,且已在2022年10月向AMD供应该产品,用于AI加速器。

全球最大的GPU公司英伟达(Nvidia)一直在要求SK海力士提供最新的HBM3内存颗粒。全球排名第一的服务器CPU公司英特尔在全新的第四代至强可扩展处理器当中也推出了配备SK海力士HBM的产品。有业内人士表示,与最高性能的DRAM相比,HBM3目前的价格已经达到其5倍。

据悉,目前已经有超过25000块英伟达计算卡加入到了训练之中。如果所有的互联网企业都在搜索引擎中加入ChatGPT这样的机器人,那么计算卡以及相应的服务器的需求量将会达到50万块,远远超过现在的产能。因此,未来,随着不断接入ChatGPT等生成式AI需求大增,HBM的需求也将呈现出暴增的态势。

HBM成为下一代具有前景的内存芯片

CPU和GPU的性能每年都在大幅提升,但支撑它们的内存半导体性能却一直相对滞后,HBM作为替代方案应运而生。HBM可以消除CPU、GPU和内存之间的性能差距造成的瓶颈,补充了现有DRAM的局限性,被认为是一种具有前景的下一代内存产品。

其中,高带宽、高延迟的特性,决定了HBM是非常适用于作为GPU显存的,也决定了其非常适合HPC高性能计算、AI计算。比如,富士通的超级计算机富岳(Fugaku)内部所用的芯片A64FX,就搭配了HBM2内存。

从上方看HBM 图片来源:富士通

SK海力士也表示,从内存的角度来看,AI聊天机器人需要高性能的DRAM和高性能的计算存储设备,可能加快市场重心转向大容量服务器内存的时间。SK海力士提到,服务器内存从64GB迁移到128GB的速度可能更快。目前,通过与中央处理器(CPU)和图形处理器(GPU)配对,可以明显提高服务器性能的HBM订单正在明显增加。

计算存储是ChatGPT的重要基石。ChatGPT3相较ChatGPT2在数据存储端从百G提升至40T在存储量上有约100倍的提升,算力需求同样也呈几何倍增长。未来,人工智能的发展和数据存储的进步将会是相辅相成的,数据存储也必将成为人工智能时代重要的一环,相关企业将迎来机遇。最新的消息表明,相关影响已经开始波及上游产业,三星和海力士目前萎靡的DRAM业务也受到相关订单增加的利好。

以ChatGPT为例,数据显示,ChatGPT的总算力消耗约为3640PF-days(即假如每秒计算一千万亿次,需要计算3640天)。另有业界消息称,ChatGPT已导入了至少1万颗英伟达高端GPU。而花旗集团则预估,ChatGPT将可能促使英伟达相关产品在12个月内销售额达到30亿至110亿美元。

当前,AI时代模型算力需求已经远超摩尔定律的速度增长,特别是在深度学习、大模型时代之后,预计5-6个月翻倍。但总体而言,大容量、大带宽等存储芯片将迎来一波人工智能创新应用机遇。

端侧AI“堆叠DRAM”技术,这些国内厂商发力!

端侧AI“堆叠DRAM”技术,这些国内厂商发力! 华邦电子重新定义AI内存:为新一代运算打造高带宽、低延迟解决方案

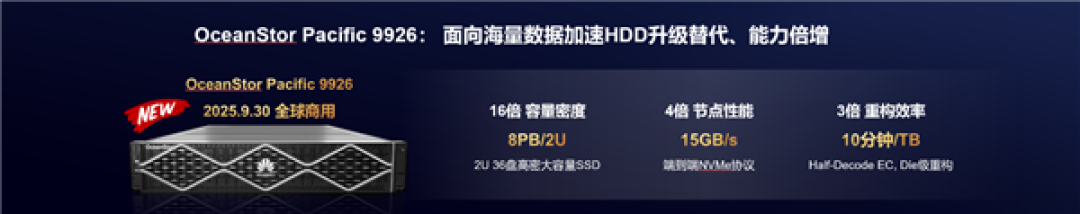

华邦电子重新定义AI内存:为新一代运算打造高带宽、低延迟解决方案 华为发布122TB超大容量SSD存储新品 1:1升级替代HDD

华为发布122TB超大容量SSD存储新品 1:1升级替代HDD  Microchip推出Adaptec® SmartRAID 4300 系列加速器 提供安全的可扩展 NVMe® RAID 存储解决方案

Microchip推出Adaptec® SmartRAID 4300 系列加速器 提供安全的可扩展 NVMe® RAID 存储解决方案

慧聪电子网微信公众号

慧聪电子网微信公众号

慧聪电子网微信视频号

慧聪电子网微信视频号

精彩评论