9月26日下午消息,在GTCChina大会上,英伟达CEO黄仁勋宣布推出全新的TensorRT3人工智能推理软件。该软件可以大幅提升云端及包括机器人、无人驾驶汽车在内的终端设备的推理性能,并有效降低成本。

据介绍,TensorRT3与英伟达GPU的结合能够基于所有的框架、为诸如图像和语音识别、自然语言处理、视觉搜索和个性化建议等人工智能服务提供快速且高效的推理。此外,TensorRT和英伟达TeslaGPU加速器的速度可达到CPU的40倍,而相较于基于CPU的解决方案,成本仅为其十分之一。

黄仁勋在现场表示,英伟达TeslaV100GPU与TensorRT结合,在处理图像时可以实现7ms延时,处理语音时延时不超过200ms,是标准云服务的理想目标。

英伟达推出TensorRT 3人工智能推理软件

而根据现场演示,由于GPU与TensorRT结合后的性能加速,一台8GPU的服务器可以替换160台双CPU服务器,或者4个机架。而每台采用TeslaV100GPU的服务器可以节省约50万美元。

黄仁勋表示,英伟达的人工智能计算平台,已经被中国互联网和IT行业的领军企业采用。阿里巴巴、百度、腾讯均已在其云端人工智能基础设施上部署了英伟达的TeslaV100GPU,而华为、浪潮、联想也已经作为OEM厂商,开始生产基于HGX的GPU服务器。

但黄仁勋同时表示,以上成绩都只是关于建立深度学习网络,而网络一旦建成,人工智能推理将会成为下一个重大挑战。

神经网络的应用会接连变革每个行业。人工智能将会注入到2000万台云服务器,以及上亿台汽车和制造机器人当中。最终,数以万计的物联网设备和传感器将能够监测从心率、血压到设备震动状态的一切数据。

而这项变革的背后,是人工智能网络架构的爆炸式增长。黄仁勋在现场介绍表示,Inception计算要求是AlexNet的50倍,DeepSpeech3的计算要求是4年前第一代的30倍,而MoE语言翻译器的计算要求是2年前OpenNMT的10倍。这对使得人工智能深度学习网络基础建成之后,人工智能推理成为该领域的下一项重大挑战。

据现场介绍,目前,阿里云、腾讯、百度云、京东、科大讯飞均已采用TensorRT3,用以支持指数级增长的人工智能工作负载。

国内FPC软板龙头,宣布FPC四层板免费打样

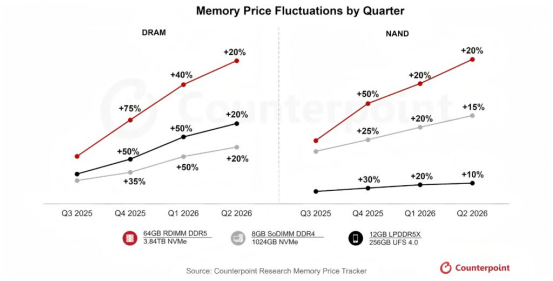

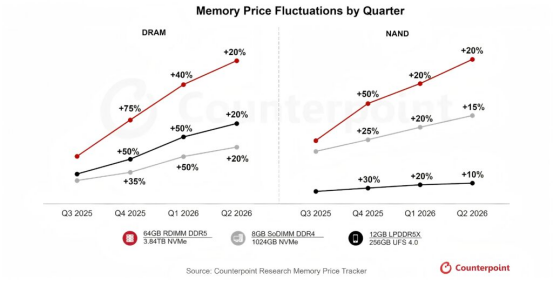

国内FPC软板龙头,宣布FPC四层板免费打样 存储暴涨50%背景下,树莓派2026年前温和调价的差异化生存策略!

存储暴涨50%背景下,树莓派2026年前温和调价的差异化生存策略! 存储价格暴涨50%席卷2026年前,树莓派官方以温和调价示好用户!

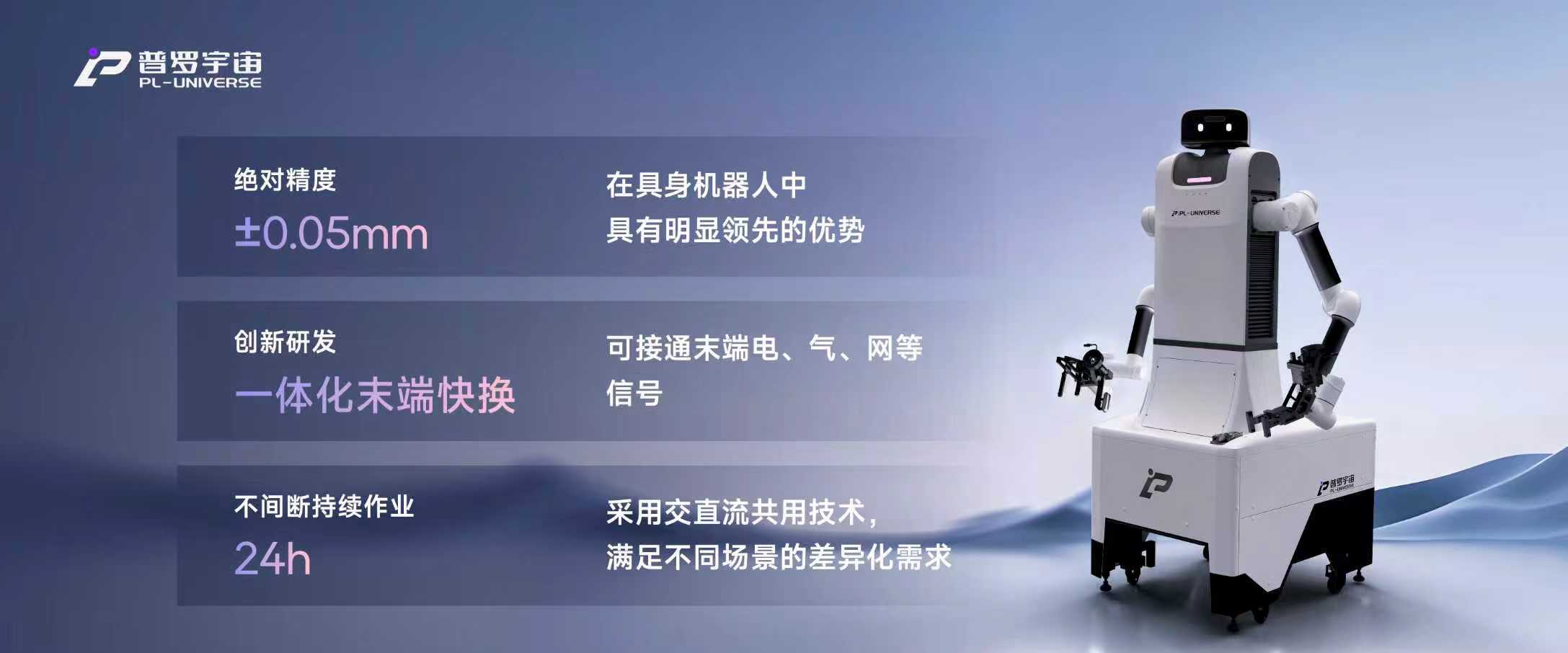

存储价格暴涨50%席卷2026年前,树莓派官方以温和调价示好用户! 黄仁勋中国行,见了一位机器人领域的女性创业者

黄仁勋中国行,见了一位机器人领域的女性创业者

慧聪电子网微信公众号

慧聪电子网微信公众号

慧聪电子网微信视频号

慧聪电子网微信视频号

精彩评论