文章概述

本文中,DigiKey介绍了使用Lattepanda Sigma开发板实现语音控制灯光项目的过程,旨在通过语音指令控制灯光开关,展现语音交互与硬件控制结合的魅力。Lattepanda Sigma因其强大的硬件性能、易于部署的软件环境、语音交互能力及AI模型部署的便利性而被选为项目核心主控。整个项目展示了如何通过现代嵌入式开发与AI技术实现自然语言控制外设的功能。

《大模型实战》系列课程的第三节,Lattepanda sigma部署大模型,实现语音控制灯光。

相关课程视频,请点击以下图片 DigiKey B站观看:

项目背景

在智能家居与物联网蓬勃发展的当下,语音控制作为一种高效、自然的交互方式,正逐渐成为提升用户体验的关键技术。通过语音指令实现灯光开关控制,不仅为日常生活带来便利,更为智能设备的开发拓展了新的思路。本项目以LattePanda Sigma开发板为核心,结合语音识别技术与AI模型,致力于打造一个语音控制灯光的智能系统,探索智能硬件与人工智能融合的创新应用。

项目概述

本项目旨在利用LattePanda Sigma开发板强大的硬件性能与丰富的功能接口,结合语音识别技术和AI模型,实现通过语音指令控制灯光开关的功能。与传统的智能家居设备(如小爱同学)不同,本项目不仅能够实现灯光控制,还具备高度的可编程性和可扩展性,开发者可以通过编写代码实现更复杂的控制逻辑和功能。

项目步骤

第一步,使用麦克风录音,使用Python的库来控制音频输入。

第二步,将语音转换为文本。

第三步,将得到的文本发送到Ollama API获取回复。

第四步,生成Arduino代码并上传,控制灯光。

项目优势

选择LattePanda Sigma作为核心主控的原因如下:

1. 卓越的硬件性能:配备高性能处理器和丰富的外设接口,能够轻松应对复杂的计算任务和外设控制需求。其板载Leonardo单片机为直接控制继电器等外设提供了便利,无需额外硬件支持。

2. 便捷的软件部署:支持Ubuntu操作系统,为开发者提供了一个稳定且易于扩展的开发环境。通过简单的系统配置和工具链安装,可以快速搭建大模型运行环境,并实现语音交互和硬件控制的自动化。

3. 强大的语音交互能力:支持USB麦克风接入,能够通过语音输入实现指令录入。结合语音识别(STT)技术和AI模型,可以实现自然语言控制外设的功能,极大地提升了用户体验。

4. 高效的AI模型部署:LattePanda Sigma的高性能计算能力使其能够运行大模型,如Ollama、Qwen等。通过简单的配置和API调用,可以快速生成适合的代码并部署到板载的Leonardo单片机,实现对外设的精确控制。

项目实现过程

硬件准备

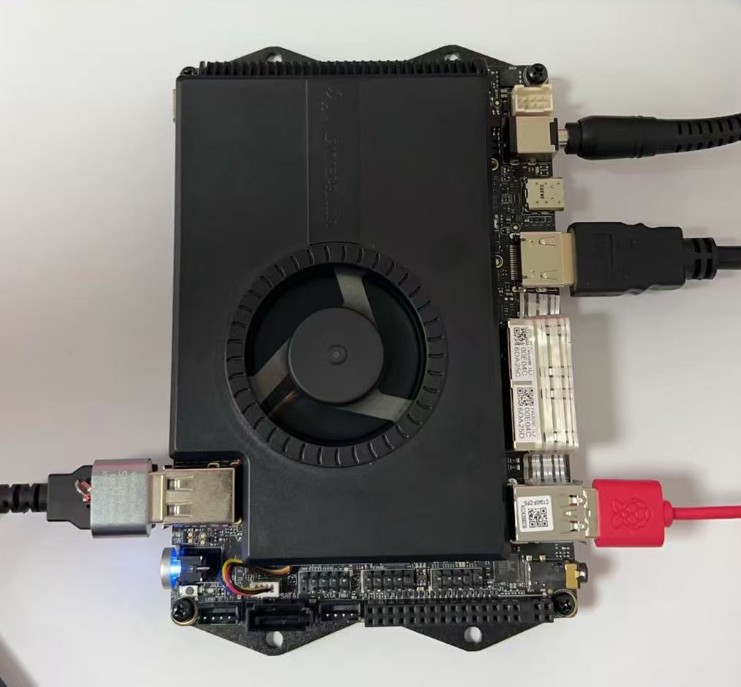

· 核心主控:LattePanda Sigma开发板

· 外围器件:

o USB麦克风

o 继电器模块

o 220V电灯和灯座

o 杜邦线

· 辅助设备:

o 支持HDMI接入的屏幕

o USB鼠标键盘

o 空白8G或更大的U盘(用于烧录系统)

实现步骤

第一步:硬件组装

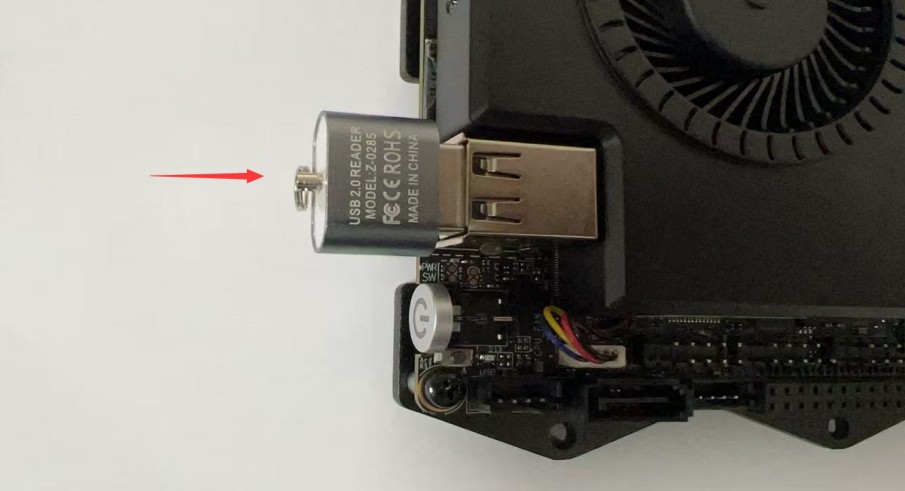

1. 将USB麦克风接入LattePanda Sigma的USB接口。

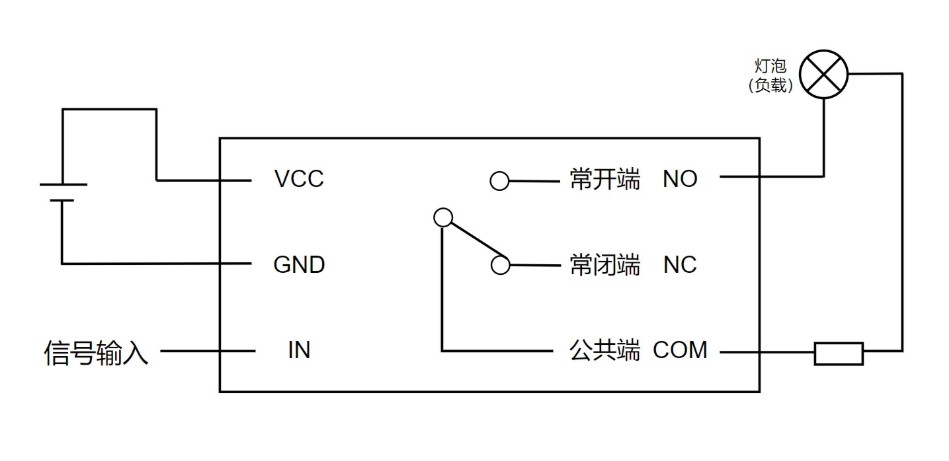

2. 将一路继电器接入开发板的IO口,其中接入一个GND,一个5V,还有一个D11接口接入继电器模块的IN接口。继电器另一端接一个电灯。

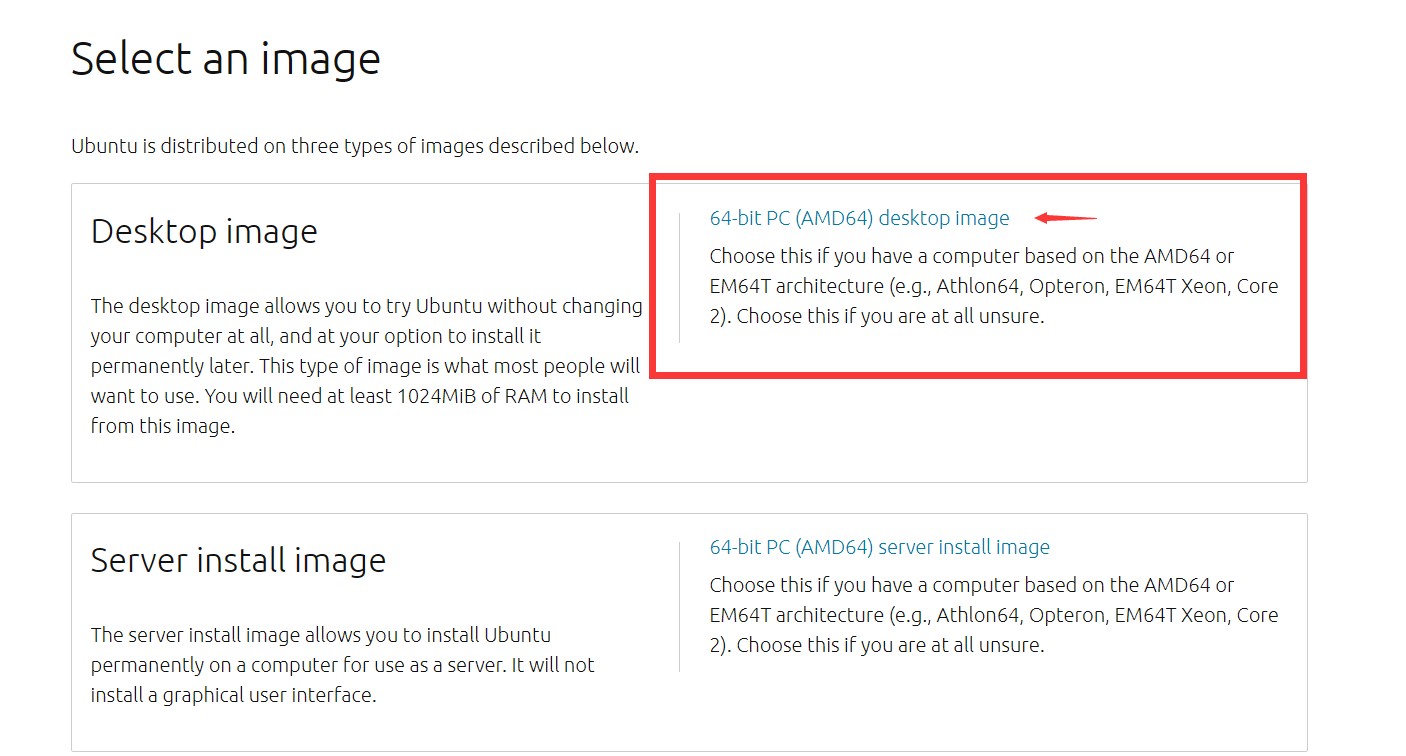

1. 下载系统镜像:根据官方推荐,下载Ubuntu 22.04 LTS版本。

https://docs.lattepanda.com/content/sigma_edition/Operating_Systems_Ubuntu/

2. 下载烧录软件:选择合适的版本下载Rufus烧录软件。https://rufus.ie/zh/

3. 烧录系统镜像:打开Rufus,找到下载好的镜像文件,将其烧录至U盘中。烧录过程中,磁盘灯会闪烁。

4. 硬件连接:将带有系统镜像的U盘插入LattePanda Sigma开发板,接入HDMI线缆、DC电源和USB键盘鼠标。

5.系统安装:以上硬件连接后,可以开机。开机后多次点击F7按键,进入启动选项设置,选择USB启动设备,继续安装,直到完成。

6.初始化配置:系统安装完成后,重启设备,拔掉USB系统安装盘,回车重启设备,进入系统。

重启后出现:

拔掉USB系统安装盘,然后回车重启设备。开发板即可进入系统:

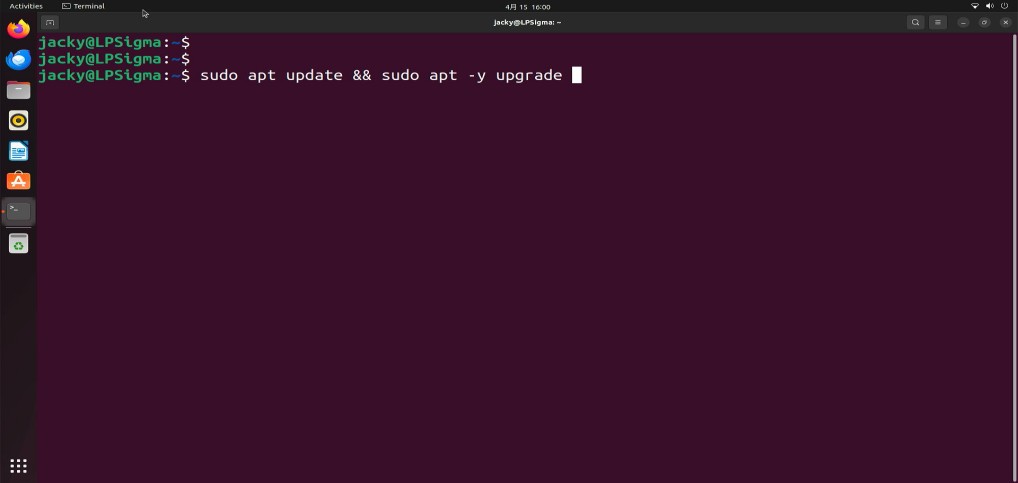

7. 更新系统:完成初始化配置后,更新系统软件仓库索引和系统软件包

8.配置软件源:根据需要定义软件的本地源,例如使用国内清华的源或阿里云的源。

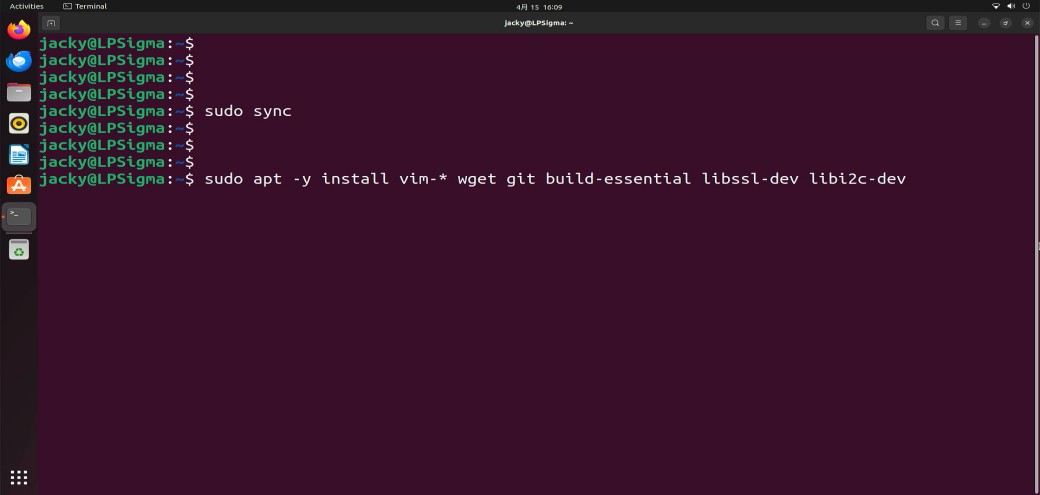

个人喜欢安装vim工具,如果你们不喜欢这步骤可以跳过。

安装了build-essential 后期后面可以做C语言的开发,很方便,当然如果后期你有在LPsigma上开发硬件设备的需求也可以安装cmake工具,例如你如果要开发树莓派pico的开发板,或者开发ESP32的开发板,都可以提前将环境安装好。

一般建议安装完后,重新启动一下设备。

第三步:安装Ollama框架

Ollama是一个开源的本地化大语言模型(LLM)运行框架,可以简化在个人计算机上部署和运行大型语言模型的过程。

Ollama支持多种安装方式,包括直接下载安装包、使用包管理器(如 Homebrew)、通过 Docker 等,而且它拥有活跃的开源社区生态,提供了大量的第三方集成和工具,包括web和桌面应用,移动应用,开发库,数据库集成等等,它的高效和安全且易于上手,对于新手非常友好,而Linux下安装也非常简单,打开终端。

1.安装curl工具:如果系统未安装curl,运行以下命令安装

2. 安装Ollama:在终端中执行以下命令安装Ollama

curl -fsSL https://ollama.ai/install.sh| sh

第四步:下载大模型

1. 下载模型:安装完成后,下载所需的模型,例如谷歌的 gemma3:4b

终端运行,进行模型下载: ollama pull gemma3:4b

2.测试模型:下载完成后,运行以下命令测试模型:

ollama run gemma3:4b --verbose

然后,就可以进入交互模式和大预言模型对话了,尝试询问一个问题看看响应的时间。

第五步:搭建Python虚拟环境及库文件

一切完成后,可以配置openssh远程登录到服务器,然后搭建python虚拟环境。

conda create -n venv -p python3.11

conda activate venv

在搭建虚拟环境前,先给大家介绍一下操作步骤:

1. 安装系统依赖:

sudo apt-get update && sudo apt-get upgrade -y

sudo apt-get install -y python3-pip python3-dev build-essential

2. 安装Python库

pip install pyaudio SpeechRecgnition

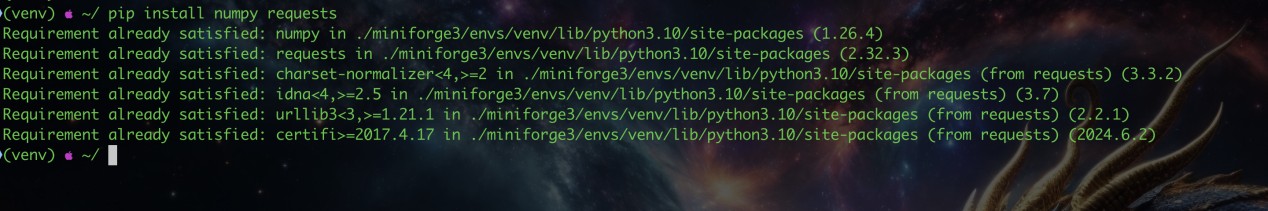

pip install numpy requests

3. 安装Arduino CLI工具

wget https://downloads.arduino.cc/arduino-cli/arduino-cli_latest_Linux_64bit.tar.gz

tar -xvf arduino-cli* && sudo mv arduino-cli /usr/bin/

arduino-cli core update-index

sudo arduino-cli core install arduino:avr

接下来,需要对语音识别进行测试,编写测试代码,通过USB 麦克风读取声音并使用pocketsphinx 进行本地语音识别。

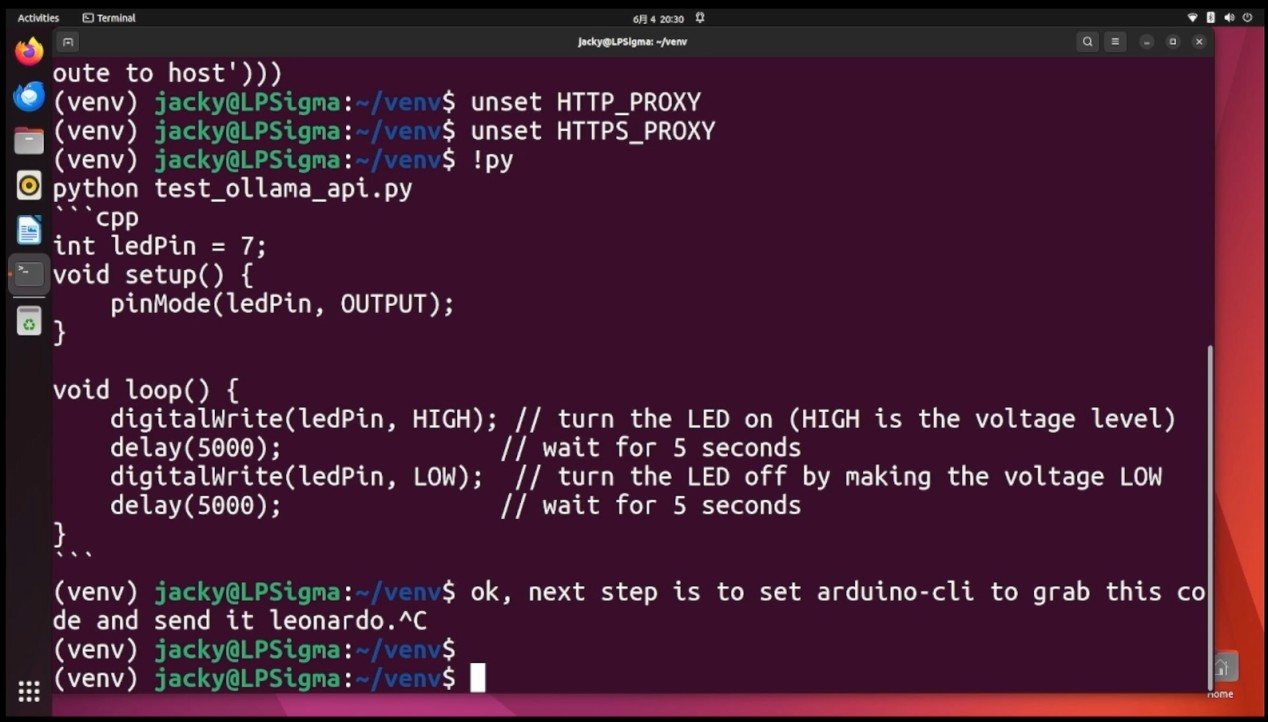

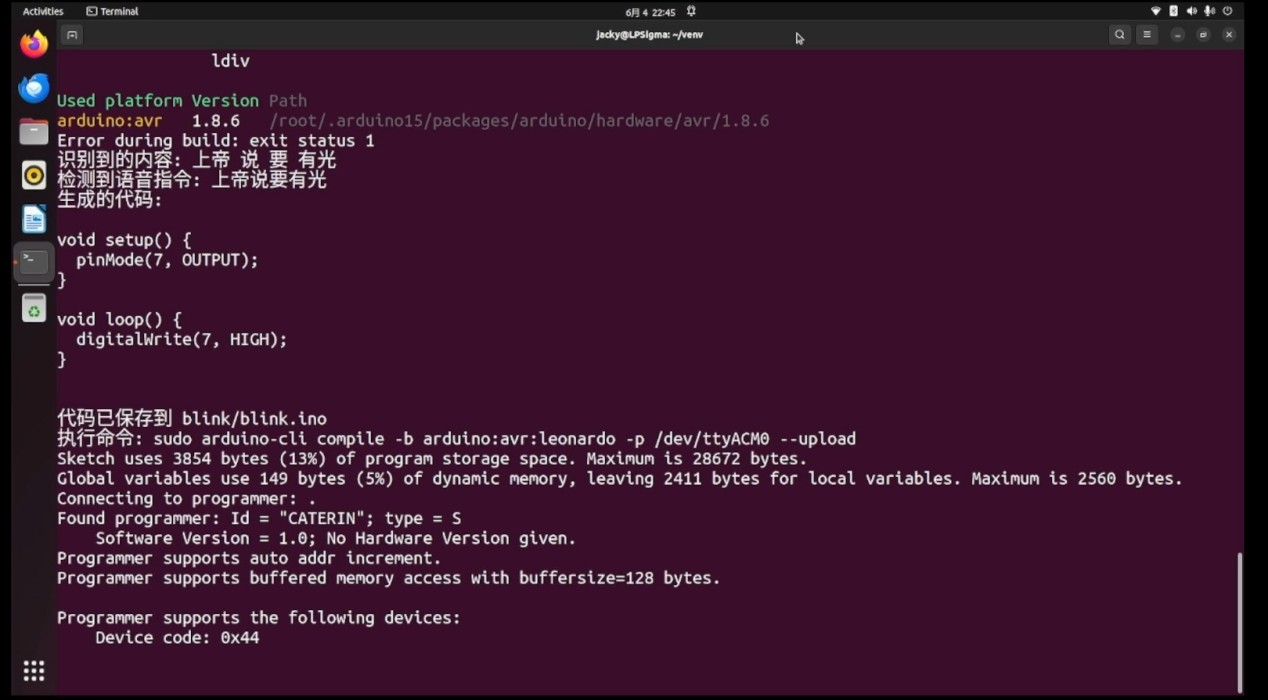

第六步:代码上传至本地Leonardo芯片

1. 上传代码:通过arduino-cli上传代码到本地的Leonardo芯片。主程序会读取模型输出并执行上传操作。

2. 运行主程序:python main.py

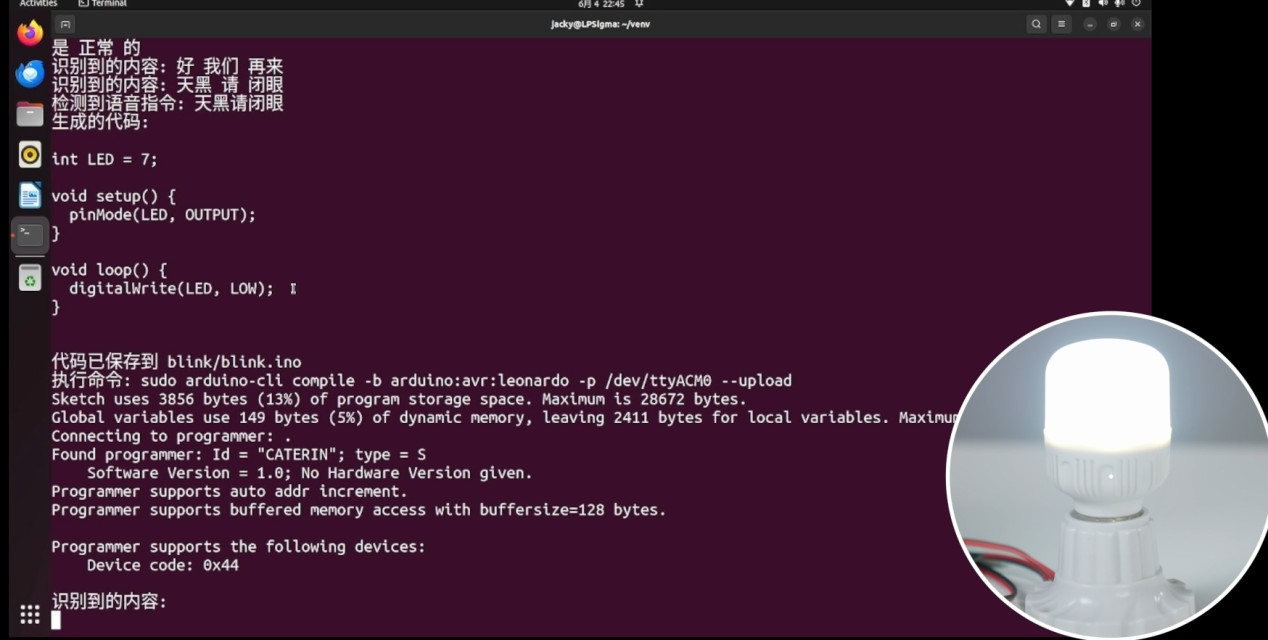

然后对着麦克风说: 上帝说要有光,Lattepanda 上有灯光闪烁,紧接着继电器闭合,外部的灯光会亮起。

对着麦克风说: 天黑请闭眼,这时候,依然会出现烧录时的灯光闪烁,关闭灯光。

这样一来,就可以实现当我们需要不同的电灯需求,只需让模型理解语意就可以实现代码重新编写和上传的功能,大家快去搭建环境试试自己的言出法随吧~

结论

通过本项目,您可以实现通过语音指令控制灯光的功能。LattePanda Sigma开发板的强大硬件性能、易于部署的软件环境、语音交互能力以及AI模型部署的便利性,使其成为实现此类项目的理想选择。您可以根据自己的需求,进一步扩展和优化项目功能。

威盛入局!从X86 “老兵” 到RISC-V “先锋”

威盛入局!从X86 “老兵” 到RISC-V “先锋” Altera Agilex 3/5 FPGA和SoC的功能特性

Altera Agilex 3/5 FPGA和SoC的功能特性

慧聪电子网微信公众号

慧聪电子网微信公众号

慧聪电子网微信视频号

慧聪电子网微信视频号

精彩评论