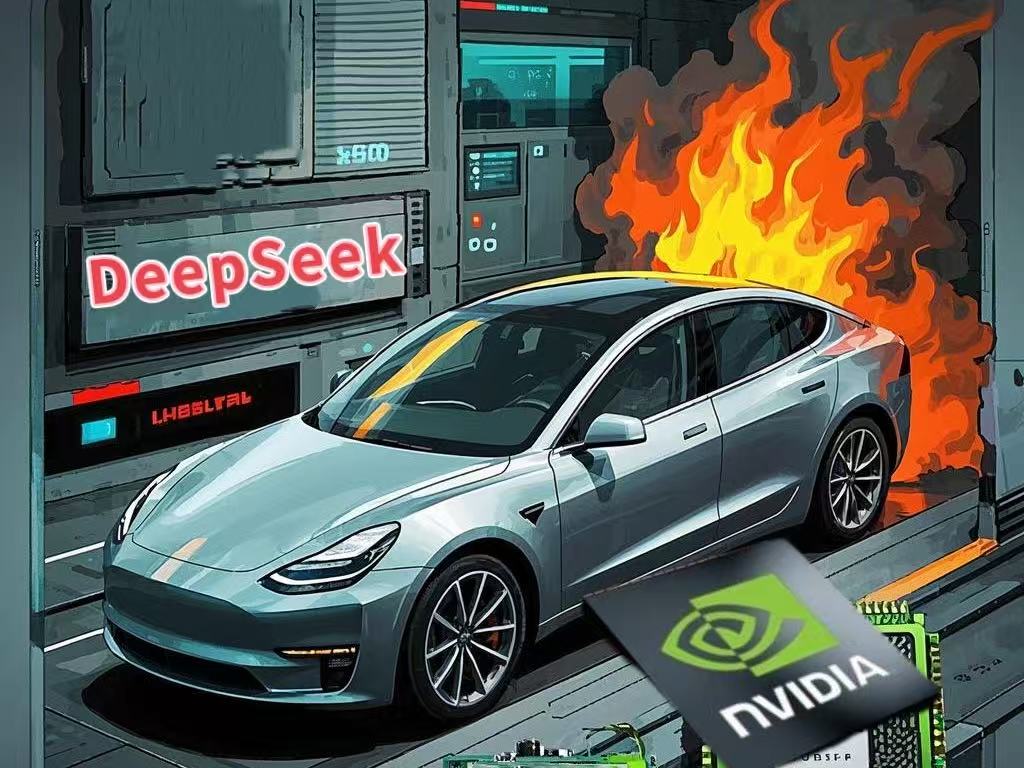

1一张显卡=一辆特斯拉?算力成本炸穿天花板

当国产大模型DeepSeek以"暴力堆算力"的姿态杀入AI战场时,行业惊呼:这哪是烧钱?这是烧命!据IDC测算,训练GPT-4级别的模型需要消耗约12.5万张英伟达H100芯片,而单张H100的售价已飙至3-4万美元,不够直观?这么说吧,这个价格足以支付特斯拉Model 3的首付。

若按特斯拉自建超算集群"Cortex"的规划规模(10万张H100)计算,仅芯片采购成本就突破30亿美元,相当于SpaceX今年计划发射的120枚猎鹰9号火箭总成本。难怪马斯克在特斯拉财报会上吐槽:"我们正在经历GPU的'大饥荒',买显卡比造火箭还烧钱!"

2算力狂飙背后:三个"血淋淋"的真相

01供需失衡:全球疯抢"AI硬通货"

2023年全球AI芯片市场出现史诗级错配:根据Gartner数据,全年H100需求量突破150万张,而英伟达实际交付量不足60万张。这种供需失衡导致国家战略级囤货,比如沙特公共投资基金(PIF)斥资4.5亿美元秘密采购3000张H100;黑市价格失控,这就不得不提到深圳华强北的翻新炒至5.2万美元。OpenAI前工程师向《华尔街日报》透露:"训练GPT-5需要约30万张H100,我们不得不把采购团队分成5组,24小时轮班给黄仁勋发邮件。"

02技术垄断:英伟达的"印钞机"

英伟达构建了从硬件到算法的绝对统治,包含:架构霸权:H100采用独家Hopper架构,其FP8精度计算效率是AMD MI300X的3.2倍;制造闭环:通过与台积电定制的4nm工艺+CoWoS-L封装技术,将竞品拦在良品率门槛之外专利围城:仅2023年就申请187项AI芯片专利,涵盖从张量核心设计到散热结构的每个细节。这种垄断形成恐怖定价权:每张H100包含的7颗芯片(1颗GPU+6颗HBM3存储芯片)物料成本仅3320美元,但售价达3.5万美元。对比奢侈品行业,这相当于把成本2万多的LV包卖到20万。即便是特斯拉这样的颠覆者,其自研的Dojo芯片目前也只能承担48%的训练任务。马斯克在X平台坦言:"我们就像同时开着燃油车和电动车,短期内根本离不开英伟达。"

03生态绑架:软件才是终极护城河

H100不仅卖硬件,更绑定英伟达的AI软件生态。英伟达真正的杀手锏在于CUDA生态,通过构建强大的软件生态系统,将硬件与软件紧密结合,进一步巩固了其市场地位。这种生态绑定使得其他竞争对手难以切入市场,也让用户对英伟达的产品形成了深度依赖。

3行业地震:谁在笑?谁在哭?

01赢家阵营:

英伟达:股价三年暴涨876%,黄仁勋皮衣成为硅谷新图腾;台积电:CoWoS封装产线毛利率达68%,超过iPhone主板两倍;特斯拉:自研Dojo芯片使其千卡集群成本降低41%,马斯克放话"2024年实现算力自给"。

02输家阵营:

AI公司:深度求索(DeepSeek)被迫将30%股权转让给腾讯,换取2000张H100使用权;云计算厂商:AWS被迫推出"算力分期付款"计划,客户需承诺三年合约才能获得H100配额;投资者:红杉资本统计显示,AI初创企业将78%融资用于购买算力,严重挤压研发投入。

03关键变量:

中国玩家的替代战争:华为昇腾910B芯片在文心一言4.0训练中实现60%替代率,但代价是训练周期延长40%。摩尔线程MTT S4000虽然通过CUDA兼容层实现部分迁移,但在千卡集群规模下,通信延迟比H100高17%。这场替代战的残酷性在于:国产芯片不仅要追赶制程差距,更要突破由500万行代码构建的软件高墙。

4未来趋势:

算力会便宜吗?短期看,H100的暴利神话难终结——全球AI军备竞赛刚进入“热战期”。在短期内,由于AI技术的快速发展和市场需求的持续增长,算力成本仍将保持高位。长期来看:技术破局:量子计算、光子芯片等新技术或颠覆游戏规则。中国科学院西安光机所在光子集成芯片领域取得了系列进展,或颠覆后续游戏规则。政策介入:欧盟已启动反垄断调查,英伟达“躺赚”模式或遭狙击;生态迁移:开源框架+国产芯片联盟,正试图绕过英伟达“高墙”。随着开源框架的普及和国产芯片的崛起,越来越多的企业开始尝试摆脱对英伟达的依赖。

5结语:

当一张显卡的价格足以买辆车时,AI的“摩尔定律”正在失效。这场算力战争没有旁观者——要么成为“铲子之王”,要么沦为“挖矿苦力”。而你我手中的每一个点赞,或许都在为未来投票。

炸榜了!华为被小米反超

炸榜了!华为被小米反超 突发!新思科技人事大地震!

突发!新思科技人事大地震! 英飞凌出售一工厂!

英飞凌出售一工厂!

慧聪电子网微信公众号

慧聪电子网微信公众号

慧聪电子网微信视频号

慧聪电子网微信视频号

精彩评论