7月21日消息,人工智能(AI)芯片初创公司Cerebras Systems于当地时间7月20日宣布,其将携手总部位于阿联酋的技术控股集团G42打造一个由9台互联的超级计算机组成的网络,为AI计算提供一种新的方案,有望大幅减少AI大模型训练时间。目前,该网络上的第一台AI超级计算机——“Condor Galaxy 1(CG-1)”开始部署,AI算力高达4 exaFLOPS(每秒4百亿亿次),这也是目前性能最强的AI超级计算机。

从全球最大的AI芯片,到全球最强AI超级计算机

提起Cerebras公司,相信有很多业内人士都听过。这是一家成立于2016年的美国AI芯片初创公司。早在2019年,Cerebras就推出了“全球最大”的AI芯片Wafer Scale Engine(以下简称“WSE”),引起了业界的极大关注。

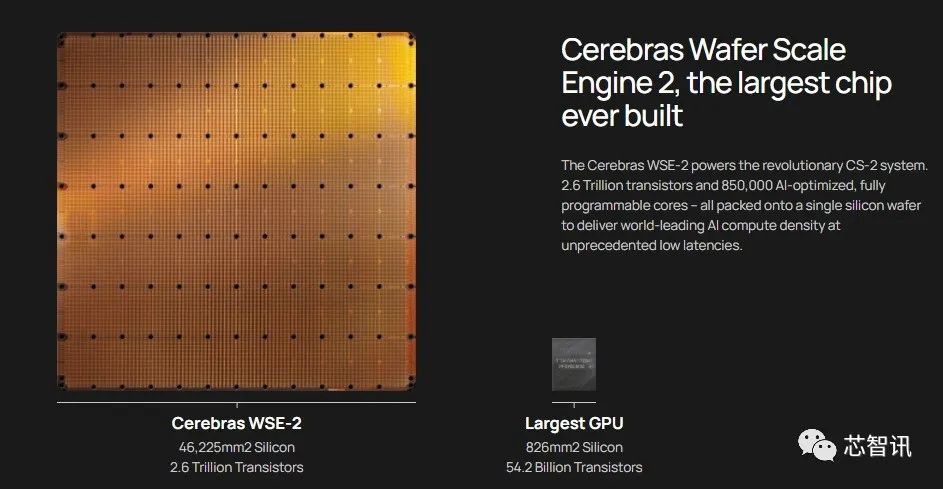

WSE一个基于一整张12英寸晶圆制造的AI芯片,基于台积电16nm工艺制造,核心面积超过46225mm²,集成了高达1.2万亿个晶体管,40万个AI核心、18GB SRAM缓存、9PB/s内存带宽、100Pb/s互连带宽,功耗也高达15千瓦。Cerebras称,其AI内核是被称为稀疏线性代数核(Sparse Linear Algebra Cores, SLAC),具有灵活性、可编程性,并针对支持所有神经网络计算的稀疏线性代数进行了优化。SLAC的可编程性保证了内核能够在不断变化的机器学习领域运行所有的神经网络算法。

随后在2021年4月,Cerebras 推出了第二代的AI芯片WSE-2。根据官方公布的数据,WSE-2与第一代一样,依然是基于一整张12吋晶圆制造,面积依然是462.25平方厘米,但是制程工艺由台积电16nm工艺提升到了7nm工艺,这也使得WSE-2的晶体管数量提高到了2.6万亿个,同时他的AI内核数量也达到了85万个,片上内存也由原来的18GB提升到了40GB,内存带宽由9PB/s提高到了20PB/s,结构带宽高达220PB/s。各项指标均打破首代WSE 处理器创造的世界纪录。

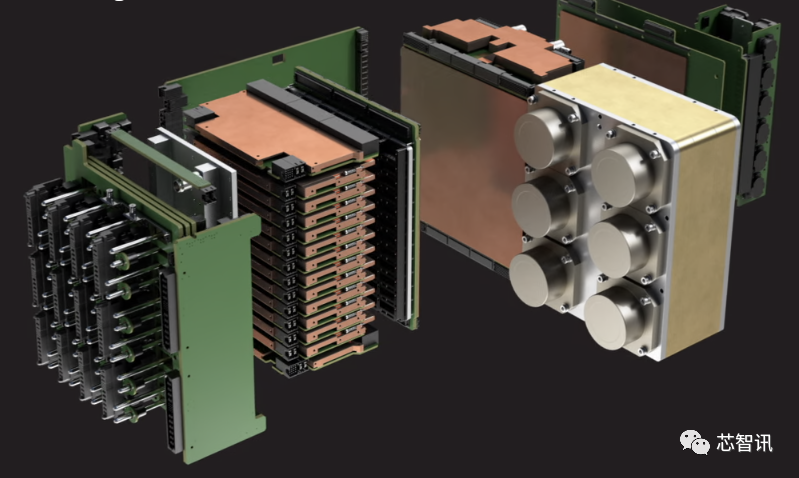

而为了推动WSE-2的商用,Cerebras还宣布推出了CS-2 AI超级计算机,其基于单个WSE-2芯片打造,不仅比任何其他AI超算系统使用空间更少、功耗更低、但运算性能更高。甚至可以支持192台CS-2 AI计算机近乎线性的扩展,从而打造出包含高达1.63亿个AI核心的计算集群,可支持超过120万亿参数的大模型的训练。

要知道目前常见的基于CPU或GPU的AI计算集群,主要是通过片外互联的模式将大量的CPU或GPU集群进行互联,从而提升AI算力,这需要大量的机架和线缆,并且花费数月的时间进行安装和准备,能耗也将达到数百千瓦以上。但是,WSE-2在单个芯片上就已经集成了更多的AI核心、拥有大的片上内存和更低延迟的高带宽结构,这也使得其在AI加速任务的处理上更具优势,功耗也更低,在安装上也更方便和节省时间,并且CS-2的能耗仅需要15kW。

△CS-2 AI超级计算机

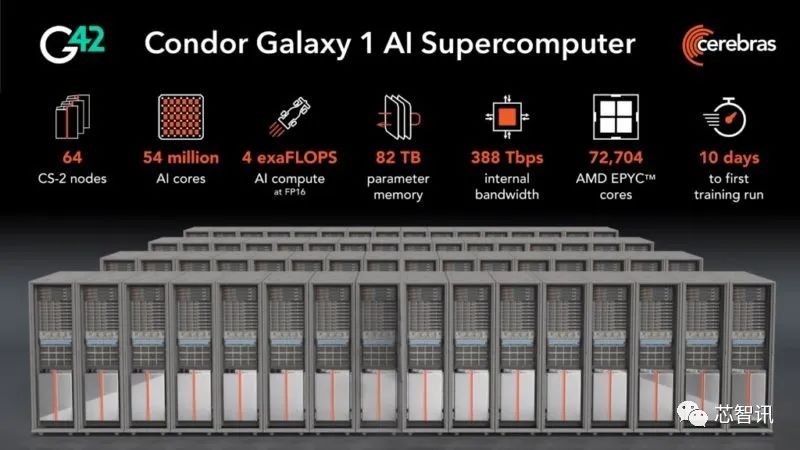

此次,Cerebras携手G42打造的算力高达4 exaFLOPS的最强AI超级计算机CG-1,正是由64台CS-2 AI计算机组合而成。

5400万个AI内核,AI算力超4 exaFLOPS

据介绍,CG-1与任何已知的GPU集群不同,其由64台CS-2 AI计算机组成,每台CS-2 AI计算机则是由一个WSE-2芯片所驱动,这也使得整个CG-1系统当中的AI内核数量达到了5400万个,总的AI算力(FP16)达到了惊人的4 exaFLOPS(400万万亿FLOPS),总体的片上内存容量达到了82TB,各个CS-2系统间的带宽速率高达388Tbps。同时,CG-1还配备了高达72704个AMD EPYC CPU内核。

CG-1针对大型语言模型和生成人工智能进行了优化,标准支持多达6000亿个参数模型。CG-1使用简单的数据并行性,就可实现从1到64个CS-2系统的近乎线性的性能扩展。扩展后的配置可支持多达100万亿个参数模型。要知道今年以来非常火爆的AI大模型GPT-4为1.8万亿个参数。

CG-1还为长序列长度的训练提供了原生支持,开箱即用的令牌多达50000个,无需任何特殊的软件库。CG-1的编程完全没有复杂的分布式编程语言,这意味着即使是最大的模型也可以轻松运行,而无需花费数周或数月的时间在数千个GPU上分配工作。

据介绍,Cerebras和G42将会把CG-1作为云服务提供,让客户无需在物理系统上管理或分发模型即可享受AI超级计算机的性能。CG-1旨在使G42及其云客户能够快速轻松地训练大型突破性模型,从而加速创新。Cerebras-G42战略合作伙伴关系已经在阿拉伯语双语聊天、医疗保健和气候研究方面推进了最先进的人工智能模型。

“CG-1在FP16上可以提供4 exaFLOP的人工智能计算,可大大缩短人工智能训练时间,同时消除了分布式计算的痛苦。” Cerebras Systems首席执行官Andrew Feldman表示:“许多云服务公司已经宣布了耗资数十亿美元构建的大规模GPU集群,但这些集群极难使用。将一个模型分布在数千个微小的GPU上需要数十名具有罕见专业知识的人花费数月时间。CG-1消除了这一挑战,单个系统耗资1亿多美元,只需要几分钟就能建立生成人工智能模型,而不是几个月,而且可以由一个人完成。”

Andrew Feldman进一步解释称,训练AI大型模型需要大量的计算、庞大的数据集和专门的人工智能专业知识。G42和Cerebras之间的合作提供了这三个要素。凭借Condor Galaxy超级计算网络,两家公司正在使人工智能民主化,使人们能够简单方便地访问行业领先的人工智能计算。G42与医疗保健、能源和气候研究领域的不同数据集的合作将使系统用户能够训练新的尖端基础模型。这些模型和衍生的应用程序是一股强大的向善力量。最后,Cerebras和G42汇集了一支由硬件工程师、数据工程师、人工智能科学家和行业专家组成的团队,提供全方位的人工智能服务,以解决客户的问题。这一组合将产生突破性的成果,并推动全球数百个人工智能项目。

G42的子公司G42 Cloud的首席执行官Talal Alkaissi也表示:“与Cerebras合作,快速交付世界上最快的人工智能训练超级计算机,并为在世界各地互连这些超级计算机奠定基础,这是非常令人兴奋的。这一合作伙伴关系汇集了Cerebras非凡的计算能力,以及G42的多行业人工智能专业知识。G42和Cerebras的共同愿景是Condor Galaxy将用于应对医疗保健、能源、气候行动等领域的社会最紧迫挑战。”

需要指出的是,位于美国加州圣塔克拉拉州的CG-1的上线,只是打造9台互联的超级计算机组成的计算网络的第一部。预计在2024年上半年,位于美国德州奥斯汀、北卡州Asheville的AI超级电脑(CG-2和CG-3)将正式上线。美国以外地区的6台AI超级电脑将于2024年下半年上线。届时,9台Condor Galaxy系统的总的AI算力将达到36 exaFLOPS。

Andrew Feldman称,这一前所未有的超级计算网络将彻底改变全球人工智能的发展。

据了解,Cerebras目前估值为41亿美元,过去数年曾获得OpenAI CEO Sam Altman、Benchmark创投募得7.4亿美元。目前,Cerebras、Graphcore、Groq和SambaNova等新创企业都希望能够打入NVIDIA所主导的AI加速芯片市场。斯坦福大学AI电脑科学家Chris Manning表示,如果无法打造AI模型的研究员习惯使用与NVIDIA芯片相兼容的软件,将使得上述新创企业处于劣势。

编辑:芯智讯-浪客剑

Alif Semiconductor发布支持生成式AI的MCU基准测试结果,巩固其在边缘AI领域的领先地位

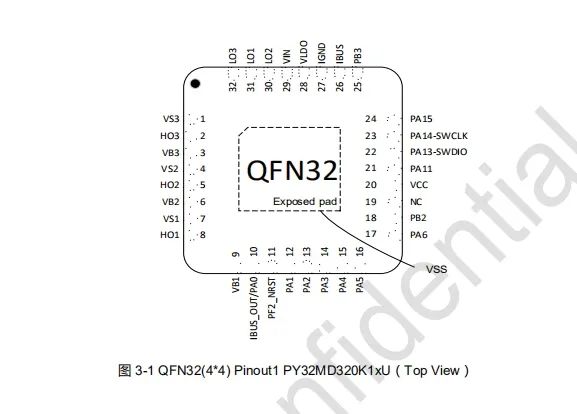

Alif Semiconductor发布支持生成式AI的MCU基准测试结果,巩固其在边缘AI领域的领先地位 普冉PY32MD320单片机技术规格概述

普冉PY32MD320单片机技术规格概述

慧聪电子网微信公众号

慧聪电子网微信公众号

慧聪电子网微信视频号

慧聪电子网微信视频号

精彩评论