量子计算机有望提供更强的计算能力。量子计算机提供了另一条增强计算能力的思路。它并行计算的特性,使得它可以一次同时处理多个任务,有望实现计算能力上的超越。

量子计算的算力呈指数级增长

量子计算的核心优势是可以实现高速并行计算。在计算机科学中,无论经典计算还是量子计算,他们的计算功能的实现都可以分解为简单的逻辑门的运算,包括:“与”门,“或”门,“非”门,“异或”门等。简单来讲,每一次逻辑门的运算(简称操作)都是要消耗一个单位时间来完成。

经典计算机的运算模式通常是一步一步进行的。它的每一个数字都是单独存储的,而且是逐个运算。所以对于4个数字进行同一个操作时,要消耗4单位时间。而量子计算中,一个2个量子比特的存储器可以同时存储4个数字,这里一个量子态可以代表所有存储的数字。

科学家通过特定设计对量子态进行一次变换,即可对4个数字同时操作,而且只消耗1单位时间。这种变换相当于经典计算的逻辑门,实现了对存储器中的数字并行运算,这被称为量子并行计算。可以看到,当量子比特数量越大时,这种运算速度的优势将越明显。它可以达到经典计算机不可比拟的运算速度和信息处理功能。

量子计算机的量子比特数量以指数形式增长,算力将以指数的指数增长。对于量子计算机,在半导体材料和超导材料等领域,科学家也已经积累了数十年的理论与经验。

现有最有希望的量子计算机方案之一就是低温超导系统,它涉及了半导体材料与超导材料的应用,主要是基于硅晶体,掺杂一定量的超导材料,实现量子计算。而现有的技术积累将极大促进该方案的发展与快速突破,用更短的时间(相比与经典计算机)实现大规模的商业化应用。

可以看到,量子计算机的量子比特数量以指数增长的形式快速上升,从2003年起的1位量子比特,到2013年512位量子比特的计算机,再到2015年实现1000位量子比特。目前,非通用型量子计算机的已经实现了1000位量子比特,在特定算法上(比如模拟退火,一种优化方法),计算效率比经典计算机要快一亿倍。

提升人工智能效率量子计算比经典算法节省大量时间

量子计算机的全球商业化进程加速

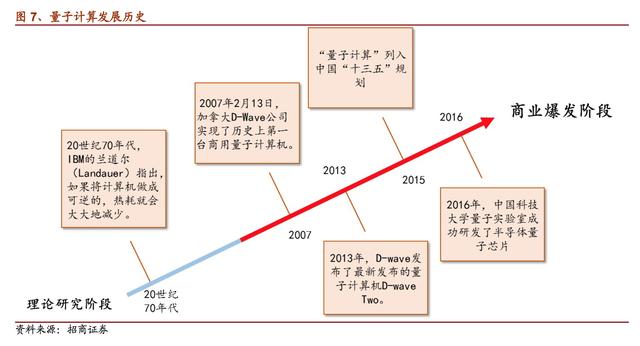

量子计算机经过近40年的时间的理论研究阶段,在2007年首次实现硬件方面商业化。目前发展迅速的是非通用型量子计算机,而通用型量子计算机还处于起步阶段。我们认为,通用型量子计算机和非通用型量子计算机最终将在市场上共存,并最终共同向经典计算机的市场份额发起挑战。

量子计算发展历史

2007年,D-wave Systems实现了历史上第一台商用量子计算机。宣布研制成功16量子比特的量子计算机——“猎户座”(Orion)。D-wave公司的量子计算机是用超导量子器件做成的。所使用量子计算机方式是绝热量子计算,是将量子计算体系放置在体系的基态,而最终的计算结果就是最后的量子体系的基态。

2011年5月11日,该公司正式发布了全球第一款商用型量子计算机“D-Wave One”,实现了128位量子比特。它不是通用量子计算机,并不能运行所有的量子算法。D-wave实际上是一台量子退火机(quantum annealing machine),在图像搜索方面确实具有优势。

Google和NASA花1000万美金买一台D-wave,共同建立了Quantum AI Lab。2013年它研制出的产品D-wave Two,实现了512位量子比特,并将其销售给了Google,用于Google内部的量子计算的相关研发。截止到2014年,该公司的累计融资总额达到1.6亿美元。

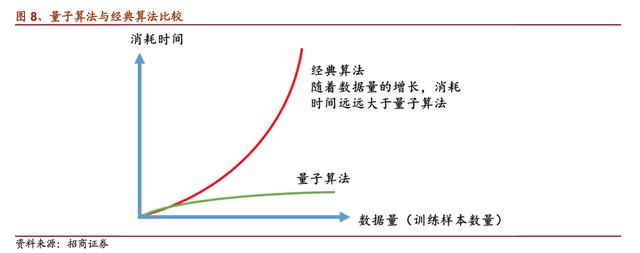

量子人工智能算法相比经典算法节省大量时间

与经典计算机不同,量子计算机使用经典算法,将无法实现并行计算。经典计算机的计算核心使用的是中央处理器,是一种基于半导体理论设计的电子芯片,用于串行运算。而量子计算机中,它的计算核心是量子芯片,通过量子的叠加性带来了并行运算的能力,替代传统的电子芯片。

可以看到,量子计算机与经典计算机的物理实现的完全不同,如果在量子计算机中使用经典算法的话,那么量子芯片将和普通电子芯片发挥基本相同的功能,只能实现串行计算。这是由于设计经典算法时,其设计思想是基于串行运算而得到的,这是经典算法自身的局限性。

需要设计相应的量子人工智能算法,才能实现量子计算的超强算力。这种专门面向量子计算设计的人工智能算法被称为量子人工智能算法。近些年,在量子人工智能算法研究放面,谷歌开始建立量子人工智实验室,包括微软等在做一些人工智能方面的东西。

这几年开始,甚至在Alpha Go出来之前,在学界就已经有一些研究成果。人工智能里面的分类问题,是大数据中常见的任务,根据已有的数据体现规律,判断新数据是属于哪一类。MIT的研究小组在这方面已经取得了理论进展,实现了相应的量子人工智能算法。相比于经典算法,该量子算法实现了指数级的加速效果。

量子算法与经典算法比较

量子计算提升人工智能效率,拓展应用场景

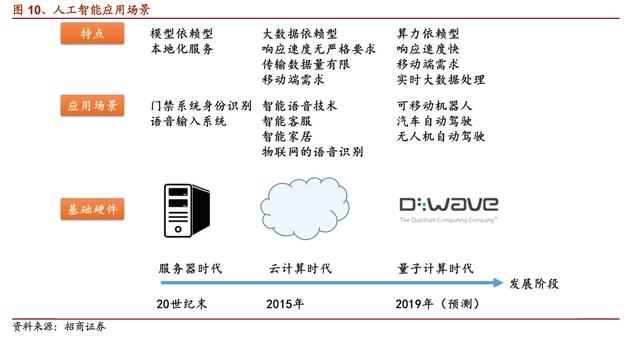

在很多应用领域,人工智能需要拥有快速处理数据、快速响应的能力。比如智能驾驶等应用场景,对于人工智能的反应速度要求很高。再比如手机上的人工智能系统,对于数据的处理能力要求非常高,没法做到这么大量的数据快速传输到服务器端。这些应用场景中,亟需人工智能的硬件系统实现可移动化和快速响应能力。

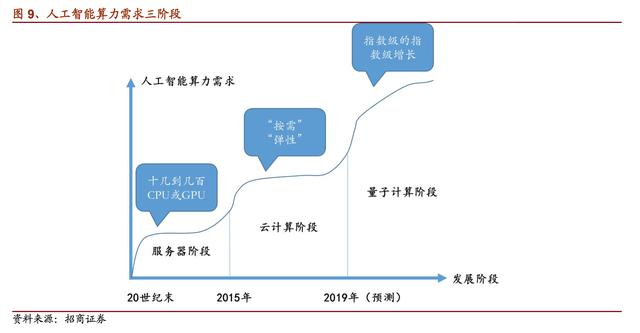

服务器、云计算、量子计算是人工智能算力发展的必经阶段

随着人工智能对硬件计算能力的需求不断提升,人工智能从单机或者小型服务器模式,逐步转型为云计算模式。目前,随着人工智能应用的发展,单机或者小型服务器模式的两个劣势逐渐显现。

一方面,这种模式可提供的算力达到了一个瓶颈阶段,已无法满足人工智能对算力的需求;

另一方面,这种模式是一次性采购的,对于用户的资金压力较大,并且后期维护成本不低,需要自己搭建相应的软件环境。现阶段一种主要的解决方案思路是将人工智能应用或者服务放在云端,运用云计算平台提供更加优质廉价的人工智能服务。主要的优点是可以按照实际需求来购买计算能力,随时满足现阶段的应用需求。另一方面是付费模式相对弹性,按照使用状况来逐次结算费用,减轻资金压力。

人工智能算力需求三阶段

提升人工智能效率量子计算比经典算法节省大量时间

随着数据量的急剧增长,量子计算的革命性算力才能满足人工智能的需求。数据量的增长速度是呈指数级变化的。在摩尔定律近乎失效的情况下,基于现有的计算能力,在如此庞大的数据面前,人工智能的训练学习过程将变得无比漫长,甚至完全无法实现最基本的功能。

而量子计算机的量子比特数量以指数形式增长,也就是每两年翻一番。又因为量子计算的特点,其计算能力是量子比特数量的指数级,所以最终随着不断发展,其算力将以指数的指数增长。这个增长速度将远远大于数据量的增长,为数据爆发时代的人工智能带来了强大的硬件基础。

实际应用:量子计算可用于大数据搜索

在大数据中进行快速搜索,这是一项适用于量子计算的计算任务。经典算法只能是一个接一个地搜寻,直到找到所要的目标为止。比如从N个未分类的客户中寻找出某个特定的客户,这种算法平均地讲要寻找N/2次,才能以1/2的概率找到。然而这样的搜索效率十分低下,对于各种大数据的应用场景基本不存在应用价值。

量子计算时代将拓展人工智能应用场景

从服务器到云计算,人工智能的应用场景得到了极大的拓展,我们认为量子计算也将拓展人工智能的应用场景。

人工智能应用场景

我们认为,人工智能的发展存在三个阶段:服务器时代、云计算时代、量子计算时代。其中量子计算时代为人工智能带来的颠覆,除了计算能力方面,更重要的是极大地增加了应用场景。

观众火热报名中!同期活动亮点纷呈,ES SHOW 2025深圳元器件展10月28-30日邀你共鉴!

观众火热报名中!同期活动亮点纷呈,ES SHOW 2025深圳元器件展10月28-30日邀你共鉴! 品英Pickering为光电信息领域提供先进的开关、仿真方案和测试系统

品英Pickering为光电信息领域提供先进的开关、仿真方案和测试系统 品英Pickering公司仿真方案和测试系统满足航电设备可靠性和安全性等更高要求

品英Pickering公司仿真方案和测试系统满足航电设备可靠性和安全性等更高要求 台积电先进封装订单激增,消息称英伟达独揽七成产能

台积电先进封装订单激增,消息称英伟达独揽七成产能

慧聪电子网微信公众号

慧聪电子网微信公众号

慧聪电子网微信视频号

慧聪电子网微信视频号

精彩评论